مدت مطالعه: 13 دقیقه

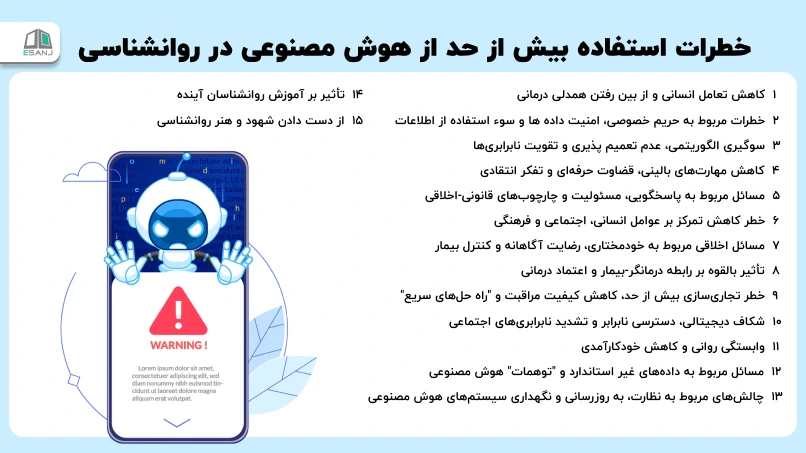

مدت مطالعه: 13 دقیقه خطرات استفاده بیش از حد از هوش مصنوعی در روانشناسی

هوش مصنوعی (AI) به سرعت در حال تبدیل شدن به یک نیروی دگرگون کننده در بسیاری از صنایع است و روانشناسی هم از این قاعده مستثنی نیست. پتانسیل هوش مصنوعی برای افزایش کارایی، دسترسی و شخصی سازی در مراقبتهای بهداشت روانی قابل توجه است.

از چت بات های مجهز به هوش مصنوعی که پشتیبانی اولیه ارائه میدهند تا الگوریتمهایی که به تشخیص اختلالات روانی کمک میکنند، هوش مصنوعی نویدبخش انقلابی در نحوه ارائه خدمات سلامت روان است. با این حال، همراه با این فرصت های هیجان انگیز، خطرات قابل توجهی هم در استفاده بیش از حد و نامناسب از هوش مصنوعی در روانشناسی وجود دارد.

تکیه بیش از حد بر هوش مصنوعی میتواند منجر به پیامدهای ناخواستهای شود که ماهیت ظریف و پیچیده سلامت روان را تضعیف می کند. این مقاله از ای سنج به بررسی عمیق این خطرات می پردازد و پیامدهای اخلاقی، بالینی و اجتماعی ناشی از وابستگی بیش از حد به هوش مصنوعی روانشناسی را مورد بحث قرار میدهد.

خطرات استفاده بیش از حد از هوش مصنوعی در روانشناسی

در این قسمت، خطرات استفاده بیش از حد از هوش مصنوعی در روانشناسی را به طور کامل مورد بررسی قرار خواهیم داد:

1. کاهش تعامل انسانی و از بین رفتن همدلی درمانی

یکی از اساسی ترین و غیرقابل جایگزین ترین جنبه های روان درمانی و ارزیابی روانشناختی، تعامل انسانی و ایجاد یک رابطه درمانی قوی است. این رابطه مبتنی بر اعتماد، همدلی، درک متقابل و یک اتحاد کاری مشترک است که برای تسهیل تغییر و رشد درمانی حیاتی است.

هوش مصنوعی، در ماهیت خود، یک سیستم مبتنی بر الگوریتم و داده است و فاقد توانایی تجربه یا ابراز واقعی احساسات انسانی، همدلی، شهود و درک ظرافت های غیرکلامی ارتباط است. تکیه بیش از حد بر چت بات های هوش مصنوعی برای ارائه "حمایت عاطفی" یا "مشاوره" یا استفاده از ابزارهای تشخیصی خودکار که نیاز به مصاحبه بالینی عمیق را کاهش می دهند، میتواند منجر به کاهش شدید تعامل چهره به چهره و ارتباط انسانی بین درمانگر و بیمار شود.

این امر می تواند توانایی درمانگر را برای ایجاد ارتباط عمیق، درک دیدگاه منحصر به فرد بیمار، پاسخگویی به نیازهای عاطفی ظریف او و خواندن نشانه های غیرکلامی که اغلب اطلاعات حیاتی را منتقل می کنند، مختل کند. از دست دادن این ارتباط انسانی می تواند منجر به احساس انزوا، عدم درک و کاهش اثربخشی درمان برای بیماران شود. بیماران ممکن است احساس کنند که صرفاً به عنوان مجموعه ای از داده ها یا یک مشکل برای حل توسط یک ماشین دیده می شوند، نه به عنوان یک فرد کامل با تجربیات و احساسات پیچیده.

همدلی، توانایی درک و به اشتراک گذاشتن احساسات دیگران، یک جزء حیاتی در ایجاد اعتماد، اعتبار بخشیدن به تجربیات بیمار و تسهیل تغییر درمانی است. سیستم های هوش مصنوعی، هر چقدر هم که پیشرفته باشند، نمی توانند همدلی واقعی را تجربه یا ابراز کنند؛ آنها میتوانند پاسخهای متنی را تولید کنند که ممکن است شبیه همدلی به نظر برسند، اما این یک شبیه سازی است، نه یک تجربه واقعی.

تکیه بر آنها برای ارائه این جنبه حیاتی درمان می تواند منجر به پاسخ های مکانیکی، غیر شخصی و حتی نامناسب شود که ممکن است نه تنها نیازهای عاطفی بیمار را برآورده نکند، بلکه به او آسیب برساند یا احساس بیاعتمادی را تقویت کند. این امر به ویژه برای افرادی که با تروما، سوء استفاده یا سایر آسیب های عاطفی دست و پنجه نرم می کنند، صادق است، جایی که یک رابطه انسانی امن و همدلانه برای بهبودی ضروری است.

2. خطرات مربوط به حریم خصوصی، امنیت داده ها و سوء استفاده از اطلاعات

روانشناسی به طور ذاتی شامل جمع آوری، ذخیره سازی و تجزیه و تحلیل اطلاعات شخصی و حساس در مورد افکار، احساسات، تجربیات، سابقه خانوادگی و حتی جزئیات صمیمی زندگی افراد است. این داده ها از حساس ترین انواع اطلاعاتی هستند که یک فرد می تواند به اشتراک بگذارد و حفاظت از آنها از اهمیت بالایی برخوردار است.

ادغام هوش مصنوعی در این زمینه، حجم، تنوع و پیچیدگی داده های جمع آوری شده و پردازش شده را به طور تصاعدی افزایش می دهد. این امر نگرانی های جدی و چند وجهی در مورد حریم خصوصی و امنیت این داده ها ایجاد می کند. سیستم های هوش مصنوعی، به ویژه مدل های یادگیری عمیق، اغلب برای عملکرد مؤثر به مقادیر عظیمی از داده های آموزشی نیاز دارند.

جمع آوری و ذخیره این داده ها، به ویژه داده های روانشناختی که بسیار خصوصی و بالقوه آسیب پذیر هستند، خطرات قابل توجهی را به همراه دارد. نقض داده ها، حملات سایبری، دسترسی غیرمجاز یا سوء استفاده از این اطلاعات می تواند پیامدهای ویرانگری برای افراد داشته باشد. این پیامدها می تواند شامل افشای اطلاعات حساس شخصی، تبعیض در زمینه های شغلی یا بیمه، آسیب به شهرت، و آسیب روانی ناشی از نقض اعتماد باشد.

علاوه بر این، الگوریتم های هوش مصنوعی مورد استفاده در روانشناسی ممکن است همیشه شفاف و قابل درک نباشند. این "جعبه سیاه" بودن می تواند تعیین نحوه تصمیم گیری سیستم، ردیابی منبع سوگیری ها یا اطمینان از استفاده اخلاقی و مسئولانه از داده ها را دشوار کند. بدون شفافیت مناسب در مورد نحوه پردازش و استفاده از داده ها، خطر سوگیری الگوریتمی و تصمیم گیری ناعادلانه افزایش می یابد.

همچنین، خطر سوء استفاده از داده های روانشناختی برای اهداف غیر درمانی وجود دارد، مانند بازاریابی هدفمند، پروفایل سازی روانشناختی برای اهداف سیاسی، یا حتی کنترل اجتماعی. اطمینان از اینکه داده ها فقط برای اهداف درمانی مورد نظر استفاده می شوند و از سوء استفاده محافظت می شوند، یک چالش بزرگ است. قوانین و مقررات فعلی ممکن است برای پرداختن به این چالش های جدید که توسط هوش مصنوعی ایجاد می شود، کافی نباشند.

3. سوگیری الگوریتمی، عدم تعمیم پذیری و تقویت نابرابریها

الگوریتم های هوش مصنوعی بر اساس داده هایی آموزش داده می شوند که به آنها داده می شود. این داده ها، که اغلب از منابع موجود جمع آوری می شوند، می توانند منعکس کننده سوگیری های اجتماعی، تاریخی و فرهنگی باشند که در جامعه وجود دارد.

اگر این داده ها دارای سوگیری باشند (به عنوان مثال، اگر به طور نامتناسبی از گروه های خاصی جمع آوری شده باشند یا منعکس کننده کلیشه های مضر باشند)، سیستم هوش مصنوعی این سوگیری ها را یاد می گیرد و آنها را در خروجی های خود تداوم می بخشد و حتی تقویت می کند. در زمینه روانشناسی، این می تواند منجر به تشخیص های نادرست، توصیه های درمانی نابرابر و تقویت نابرابری های موجود در مراقبت های بهداشت روانی شود.

به عنوان مثال، اگر یک سیستم هوش مصنوعی تشخیصی بر روی داده هایی آموزش داده شود که عمدتاً از جمعیت های سفیدپوست، مرد و غربی جمع آوری شده است، ممکن است در تشخیص دقیق شرایط سلامت روان در افراد از گروه های اقلیت قومی، جنسیتی، فرهنگی یا اجتماعی-اقتصادی با مشکل مواجه شود.

این می تواند منجر به تشخیص های نادرست (هم تشخیص بیش از حد و هم تشخیص کمتر)، عدم ارائه مراقبت مناسب، یا ارائه توصیه های درمانی نامناسب برای این گروه ها شود. سوگیری می تواند در مراحل مختلف چرخه عمر هوش مصنوعی رخ دهد: از جمع آوری داده ها (داده های ناقص یا نامتعادل) تا طراحی الگوریتم (سوگیری های تعبیه شده توسط توسعه دهندگان) و تا تفسیر نتایج.

علاوه بر این، یافته های حاصل از سیستم های هوش مصنوعی که بر روی یک جمعیت خاص آموزش داده شده اند، ممکن است به طور کلی برای جمعیت های دیگر قابل تعمیم نباشند. این امر می تواند محدودیت هایی را در استفاده از هوش مصنوعی برای تحقیق و عمل روانشناختی در زمینه های مختلف فرهنگی و جمعیتی ایجاد کند.

آنچه در یک فرهنگ "عادی" تلقی می شود، ممکن است در فرهنگ دیگر اینگونه نباشد، و سیستم های هوش مصنوعی که فاقد درک فرهنگی عمیق هستند، ممکن است این تفاوت ها را اشتباه تفسیر کنند. این امر می تواند منجر به آسیب رساندن به بیماران و تضعیف اعتماد به فناوری شود.

برای مقابله با این مشکل، توسعه دهندگان هوش مصنوعی و روانشناسان باید فعالانه برای ایجاد مجموعه داده های آموزشی متنوع و نماینده و همچنین برای توسعه الگوریتمهایی که میتوانند به طور عادلانه و بدون سوگیری در جمعیتهای مختلف عمل کنند، تلاش کنند.

4. کاهش مهارتهای بالینی، قضاوت حرفهای و تفکر انتقادی

تکیه بیش از حد بر هوش مصنوعی می تواند منجر به کاهش مهارت های بالینی و اضمحلال قضاوت حرفه ای در بین روانشناسان شود. اگر متخصصان به طور فزاینده ای به سیستم های هوش مصنوعی برای تشخیص، برنامه ریزی درمان، انتخاب مداخلات و تصمیم گیری بالینی تکیه کنند، ممکن است فرصت های خود را برای توسعه و تقویت مهارت های حیاتی همانند مشاهده بالینی دقیق، مهارت های مصاحبه پیشرفته، فرمول بندی مورد پیچیده، تفکر انتقادی، و توانایی ادغام اطلاعات از منابع متعدد از دست بدهند.

قضاوت بالینی یک مهارت پیچیده و ظریف است که شامل ادغام دانش نظری، شواهد تحقیقاتی، تجربه عملی و درک شهودی از بیمار در یک زمینه منحصر به فرد است. این یک فرآیند تکراری و پویا است که از طریق تجربه و تعامل مستقیم و عمیق با بیماران در طول زمان به دست می آید. تکیه بیش از حد بر سیستم های هوش مصنوعی که ممکن است فاقد این درک ظریف باشند و فقط بر اساس داده های موجود عمل کنند، می تواند منجر به تصمیم گیری های کمتر آگاهانه، مکانیکی و بالقوه مضر شود.

علاوه بر این، اگر روانشناسان به طور کامل به توصیه های ارائه شده توسط سیستم های هوش مصنوعی اعتماد کنند بدون اینکه آنها را به طور انتقادی ارزیابی کنند، خطر "اتوماسیون سوگیری" (automation bias) افزایش می یابد. این پدیده زمانی رخ میدهد که انسان ها بیش از حد به سیستمهای خودکار اعتماد می کنند و تمایل دارند توصیههای آنها را حتی زمانی که اشتباه هستند، بپذیرند.

این میتواند منجر به اشتباهات تشخیصی، تصمیمات درمانی نامناسب و ناتوانی در شناسایی نقاط ضعف یا خطاهای سیستم هوش مصنوعی شود. برای حفظ صلاحیت حرفه ای، روانشناسان باید همچنان به توسعه مهارتهای بالینی خود ادامه دهند و هوش مصنوعی را به عنوان یک ابزار کمکی ببینند، نه یک جایگزین برای تخصص و قضاوت انسانی.

5. مسائل مربوط به پاسخگویی، مسئولیت و چارچوبهای قانونی-اخلاقی

ادغام هوش مصنوعی در روانشناسی سؤالات پیچیده و بی سابقه ای را در مورد پاسخگویی و مسئولیت ایجاد می کند. اگر یک سیستم هوش مصنوعی تشخیص نادرستی ارائه دهد، توصیه درمانی نامناسبی ارائه دهد یا منجر به یک مداخله ناموفق شود که به بیمار آسیب می رساند، چه کسی مسئول خواهد بود؟ آیا توسعه دهنده سیستم هوش مصنوعی، روانشناسی که از آن استفاده کرده است، بیمارستان یا کلینیکی که سیستم را پیاده سازی کرده است یا خود سیستم هوش مصنوعی مسئول است؟

چارچوب های قانونی و اخلاقی موجود که برای عمل روانشناختی طراحی شده اند، ممکن است برای پرداختن به این مسائل جدید که توسط هوش مصنوعی ایجاد می شود، کافی نباشند.

تعیین مسئولیت در موارد مربوط به هوش مصنوعی می تواند بسیار دشوار باشد، زیرا تصمیمات اغلب بر اساس الگوریتم های پیچیده، مدل های آماری و مقادیر زیادی از داده ها انجام می شود که ممکن است برای انسان ها به طور کامل قابل درک نباشند. فقدان شفافیت در نحوه عملکرد برخی از سیستم های هوش مصنوعی (جعبه سیاه) می تواند این موضوع را بیشتر پیچیده کند و ردیابی علت اصلی خطا را دشوار سازد.

روانشناسان باید درک روشنی از قابلیتها، محدودیتها و خطرات بالقوه سیستم های هوش مصنوعی مورد استفاده خود داشته باشند و مسئولیت نهایی تصمیمات بالینی خود را بر عهده بگیرند. تکیه صرف بر "اقتدار" هوش مصنوعی بدون ارزیابی انتقادی خروجی های آن نه تنها از نظر اخلاقی قابل قبول نیست، بلکه میتواند منجر به سهل انگاری حرفهای شود.

نیاز فوری به توسعه چارچوب های قانونی و اخلاقی جدید وجود دارد که به طور خاص به مسائل پاسخگویی و مسئولیت در زمینه هوش مصنوعی در مراقبتهای بهداشت روانی می پردازد. این چارچوبها باید نقشها و مسئولیت های همه ذینفعان، از جمله توسعه دهندگان، ارائه دهندگان خدمات و کاربران نهایی را به وضوح تعریف کنند.

نظرسنجیها از متخصصان سلامت روان نشان میدهد که بیش از 50 درصد آنها نگران خطرات بالقوه استفاده بیرویه از هوش مصنوعی، به ویژه در زمینه از دست رفتن ارتباط انسانی و مسائل مربوط به حریم خصوصی هستند.

6. خطر کاهش تمرکز بر عوامل انسانی، اجتماعی و فرهنگی

سلامت روان یک پدیده چند وجهی است که تحتتأثیر عوامل پیچیده ای از جمله عوامل بیولوژیکی (ژنتیک، شیمی مغز)، روانشناختی (افکار، احساسات، تجربیات فردی)، اجتماعی (روابط، حمایت اجتماعی، وضعیت اقتصادی-اجتماعی) و فرهنگی (هنجارها، ارزش ها، باورها) قرار دارد.

در حالی که هوش مصنوعی می تواند در تجزیه و تحلیل داده های بیولوژیکی و روانشناختی (همانند الگوهای گفتاری، داده های فیزیولوژیکی) کمک کند، ممکن است در درک کامل و ادغام عوامل اجتماعی و فرهنگی که به طور عمیق بر سلامت روان افراد تأثیر می گذارند، با مشکل مواجه شود.

تکیه بیش از حد بر رویکردهای مبتنی بر هوش مصنوعی که ممکن است بر داده های کمی و قابل اندازه گیری تمرکز کنند، می تواند منجر به کاهش تمرکز بر اهمیت روابط اجتماعی، حمایت اجتماعی، عوامل اقتصادی، نابرابری های سیستمی و زمینه های فرهنگی در ایجاد و حفظ سلامت روان شود.

این امر میتواند منجر به مداخلات درمانی شود که از پرداختن به علل ریشه ای مشکلات سلامت روان ناتوان هستند و به جای آن بر علائم سطحی تمرکز میکنند. به عنوان مثال، یک سیستم هوش مصنوعی ممکن است افسردگی را تشخیص دهد، اما نتواند نقش فقر، تبعیض یا انزوای اجتماعی را در تجربه فرد به طور کامل درک کند.

روانشناسان باید اطمینان حاصل کنند که استفاده از هوش مصنوعی مکمل یک رویکرد جامع، کل نگر و انسان محور برای درک و درمان سلامت روان است که تمام جنبههای زندگی بیمار را در نظر میگیرد.

این به معنای ادغام دادههای هوش مصنوعی با درک عمیق از زمینه اجتماعی-فرهنگی بیمار، تجربیات زندگی، نقاط قوت و منابع او است. هوش مصنوعی باید به عنوان ابزاری برای افزایش درک ما از پیچیدگیهای سلامت روان عمل کند، نه اینکه آن را به یک سری دادههای قابل اندازه گیری تقلیل دهد.

7. مسائل اخلاقی مربوط به خودمختاری، رضایت آگاهانه و کنترل بیمار

استفاده از هوش مصنوعی در روانشناسی سؤالات مهمی را در مورد خودمختاری بیمار و رضایت آگاهانه ایجاد میکند. بیماران باید به طور کامل و شفاف از نحوه استفاده از هوش مصنوعی در مراقبتهای خود، از جمله جمع آوری، ذخیره سازی و تجزیه و تحلیل دادههای آنها، آگاه باشند. آنها همچنین باید حق داشته باشند که از استفاده از هوش مصنوعی در درمان خود انصراف دهند بدون اینکه کیفیت مراقبت آنها به خطر بیفتد.

شفافیت در مورد قابلیتها و محدودیتهای سیستم های هوش مصنوعی مورد استفاده و همچنین خطرات و مزایای بالقوه آنها، برای اطمینان از رضایت آگاهانه معتبر ضروری است. بیماران باید درک کنند که چگونه دادههای آنها استفاده میشود، چه کسی به آنها دسترسی دارد، چگونه تصمیمات مبتنی بر هوش مصنوعی اتخاذ میشوند و چه مکانیزمهایی برای اعتراض یا اصلاح وجود دارد. این امر به ویژه در مورد سیستمهای هوش مصنوعی که از دادههای بیمار برای آموزش مدلهای جدید استفاده میکنند، مهم است.

علاوه بر این، استفاده از سیستمهای هوش مصنوعی که میتوانند به طور خودکار تصمیم بگیرند یا مداخلات را بدون دخالت انسانی مستقیم انجام دهند (همانند ربات های درمانی مستقل)، نگرانیهایی را در مورد خودمختاری بیمار و کنترل او بر فرآیند درمان ایجاد میکند.

روانشناسان باید اطمینان حاصل کنند که استفاده از هوش مصنوعی استقلال بیمار را تضعیف نمیکند و آنها همچنان در تصمیم گیریهای مربوط به مراقبتهای خود نقش فعالی دارند. هدف باید توانمندسازی بیماران باشد، نه سلب قدرت از آنها. این شامل اطمینان از این است که بیماران همیشه حق انتخاب و توانایی رد توصیههای هوش مصنوعی را دارند.

8. تأثیر بالقوه بر رابطه درمانگر-بیمار و اعتماد درمانی

رابطه درمانی که اغلب به عنوان اتحاد درمانی یا اتحاد کاری شناخته میشود، یک عامل پیشبینی کننده قوی و ثابت برای نتایج موفقیت آمیز درمانی است. این رابطه مبتنی بر اعتماد، احترام متقابل، درک همدلانه و یک حس همکاری مشترک است. استفاده نامناسب یا بیش از حد از هوش مصنوعی میتواند این رابطه ظریف و حیاتی را تهدید کند.

اگر بیماران احساس کنند که توسط یک سیستم هوش مصنوعی قضاوت میشوند یا با آنها تعامل میشود یا اگر احساس کنند که درمانگرشان بیش از حد به فناوری تکیه میکند، ممکن است احساس ناراحتی، عدم ارتباط یا عدم تمایل به اشتراک گذاری افکار و احساسات عمیق و آسیب پذیر خود داشته باشند.

فقدان ارتباط انسانی و همدلی واقعی که در تعاملات هوش مصنوعی وجود دارد، میتواند مانع ایجاد یک اتحاد درمانی قوی شود. بیماران ممکن است احساس کنند که نمیتوانند به یک ماشین اعتماد کنند یا اینکه ماشین نمیتواند آنها را به طور کامل درک کند.

علاوه بر این، اگر روانشناسان بیش از حد به هوش مصنوعی تکیه کنند، ممکن است ناخواسته از مسئولیتهای خود در ایجاد و حفظ این رابطه کناره گیری کنند. این میتواند منجر به کاهش کیفیت مراقبت و کاهش اثربخشی درمان شود، حتی اگر سیستمهای هوش مصنوعی دادههای "دقیق" را ارائه دهند.

روانشناسان باید به دقت در نظر بگیرند که چگونه ادغام هوش مصنوعی بر پویایی رابطه درمانی تأثیر میگذارد و اطمینان حاصل کنند که فناوری برای افزایش، نه تضعیف، ارتباط انسانی، اعتماد و همدلی استفاده می شود. هوش مصنوعی باید به عنوان یک ابزار پشتیبانی برای درمانگر عمل کند تا بتواند رابطه درمانی را تقویت کند، نه اینکه آن را به خطر بیندازد.

9. خطر تجاریسازی بیش از حد، کاهش کیفیت مراقبت و "راه حلهای سریع"

همانطور که هوش مصنوعی به طور فزاینده ای در روانشناسی ادغام می شود، خطر تجاری سازی بیش از حد مراقبتهای بهداشت روانی و کاهش کیفیت مراقبت وجود دارد. شرکتها ممکن است انگیزه داشته باشند که سیستمهای هوش مصنوعی را به عنوان راه حلهای ارزانتر، سریعتر و کارآمدتر برای مشکلات سلامت روان به بازار عرضه کنند که میتواند منجر به فشار برای کاهش زمان و منابع اختصاص یافته به مراقبتهای انسانی شود.

تمرکز بر کارایی، مقیاس پذیری و کاهش هزینهها نباید به قیمت رفاه بیمار و اثربخشی درمان تمام شود. سلامت روان یک حوزه پیچیده و ظریف است که اغلب به مداخلات طولانی مدت، شخصی سازی شده و مبتنی بر رابطه نیاز دارد.

روانشناسان باید از استفاده غیر انتقادی از سیستمهای هوش مصنوعی که ممکن است استانداردهای مراقبت را به خطر بیندازند یا به دنبال ارائه "راه حلهای سریع" برای مشکلات پیچیده باشند، محتاط باشند. این میتواند منجر به درمانهای سطحی، عدم رسیدگی به مسائل ریشهای و ناامیدی برای بیماران شود.

علاوه بر این، مدلهای تجاری مبتنی بر هوش مصنوعی ممکن است انگیزههایی ایجاد کنند که با بهترین منافع بیمار در تضاد هستند، همانند جمعآوری بیش از حد دادهها برای اهداف بازاریابی یا توسعه محصول یا ارائه خدمات مبتنی بر الگوریتم که به جای نیازهای فردی بیمار، بر سودآوری تمرکز دارند. روانشناسان باید از این پویایی های تجاری آگاه باشند و از دفاع از بیماران خود در برابر سوء استفاده یا مراقبتهای با کیفیت پایین اطمینان حاصل کنند.

10. شکاف دیجیتالی، دسترسی نابرابر و تشدید نابرابریهای اجتماعی

دسترسی به فناوری، سواد دیجیتالی و اتصال به اینترنت پرسرعت در بین جمعیتهای مختلف در سراسر جهان و حتی در داخل کشورها متفاوت است. تکیه بیش از حد بر راه حلهای مبتنی بر هوش مصنوعی میتواند شکاف دیجیتالی موجود را تشدید کرده و دسترسی نابرابر به مراقبتهای بهداشت روانی را ایجاد کند.

افرادی که فاقد دسترسی به فناوری، مهارتهای لازم برای استفاده از آن یا حتی اتصال اینترنت قابل اعتماد هستند، ممکن است از مزایای هوش مصنوعی در روانشناسی محروم شوند و دسترسی آنها به مراقبتهای با کیفیت بهداشت روانی محدودتر شود.

این امر به ویژه برای جمعیتهای آسیب پذیر همانند افراد مسن، افراد کم درآمد، ساکنان مناطق روستایی و افرادی که دارای معلولیت های خاص هستند، صادق است. اگر خدمات بهداشت روانی به طور فزاینده ای به پلتفرمهای هوش مصنوعی منتقل شوند، این گروهها ممکن است به طور فزایندهای از سیستم مراقبت حذف شوند. این مسئله میتواند نابرابریهای اجتماعی-اقتصادی و بهداشتی موجود را تشدید کند.

روانشناسان و سیاست گذاران باید از این نابرابریهای بالقوه آگاه باشند و برای اطمینان از اینکه فناوری برای بهبود دسترسی به مراقبتهای بهداشت روانی برای همه افراد، صرف نظر از وضعیت اقتصادی اجتماعی، سواد دیجیتالی یا موقعیت جغرافیایی آنها، استفاده می شود، تلاش کنند.

این موضوع ممکن است شامل توسعه راه حلهای هوش مصنوعی باشد که به حداقل نیازهای فناوری نیاز دارند، ارائه آموزش و پشتیبانی برای استفاده از فناوری و اطمینان از اینکه گزینههای مراقبت غیر هوش مصنوعی همچنان در دسترس هستند.

11. وابستگی روانی و کاهش خودکارآمدی

استفاده بیش از حد از هوش مصنوعی در روانشناسی، به ویژه در قالب چت باتهای درمانی یا ابزارهای تصمیم گیری، میتواند منجر به ایجاد وابستگی روانی در کاربران شود. اگر افراد برای راهنمایی، حمایت عاطفی یا حتی تصمیم گیریهای شخصی به طور مداوم به هوش مصنوعی تکیه کنند، ممکن است توانایی خود را برای حل مشکلات، مقابله با چالشها و توسعه مهارتهای خودکارآمدی کاهش دهند.

این پدیده که گاهی اوقات "مشکل استفاده از چت بات هوش مصنوعی (PACU)" نامیده میشود، میتواند منجر به از دست دادن خوداتکایی در حل مشکلات و حتی انزوا از دنیای واقعی شود. افراد ممکن است به دلیل تکیه بیش از حد بر چت باتهای هوش مصنوعی برای حمایت عاطفی، سطوح بالاتری از اضطراب و افسردگی را تجربه کنند.

این وابستگی بیش از حد میتواند تعاملات اجتماعی در زندگی واقعی آنها را مختل کند و منجر به انزوا و روابط تیره شود. در بلندمدت، این مسئله میتواند به جای تقویت سلامت روان، آن را تضعیف کند.

هدف روان درمانی، توانمندسازی افراد برای توسعه منابع درونی و مهارتهای مقابلهای برای مدیریت چالش های زندگی است. تکیه بر هوش مصنوعی که این مسئولیت را از فرد سلب میکند، میتواند مانع این فرآیند حیاتی شود.

12. مسائل مربوط به دادههای غیر استاندارد و "توهمات" هوش مصنوعی

سیستمهای هوش مصنوعی، به ویژه مدلهای زبان بزرگ (LLMs)، بر روی مجموعه دادههای عظیمی از متن و گاهی اوقات تصاویر آموزش داده میشوند. در حالی که این مدلها میتوانند پاسخهای بسیار منسجم و قانع کنندهای تولید کنند، آنها "درک" واقعی از جهان ندارند. آنها میتوانند اطلاعات نادرست یا بی معنی را به روشی بسیار معتبر ارائه دهند، پدیده ای که اغلب به آن "توهم" (hallucination) هوش مصنوعی گفته میشود.

در زمینه روانشناسی، این میتواند پیامدهای جدی داشته باشد. اگر یک سیستم هوش مصنوعی اطلاعات نادرست یا توصیههای مضر را به یک بیمار ارائه دهد، میتواند به طور جدی به رفاه او آسیب برساند. به عنوان مثال، یک چت بات ممکن است اطلاعات پزشکی نادرست در مورد داروها یا شرایط سلامت روان ارائه دهد یا توصیههای درمانی را ارائه دهد که از نظر بالینی نامناسب یا حتی خطرناک هستند.

علاوه بر این، دادههای روانشناختی اغلب غیر استاندارد، کیفی و بسیار شخصی هستند. تفسیر این دادهها نیاز به قضاوت انسانی و درک زمینه دارد. سیستمهای هوش مصنوعی ممکن است در پردازش و تفسیر این نوع دادهها با مشکل مواجه شوند که می تواند منجر به نتایج نادرست یا ناقص شود. اطمینان از صحت و اعتبار اطلاعات ارائه شده توسط هوش مصنوعی و توانایی تشخیص "توهمات" آن برای روانشناسان حیاتی است.

13. چالشهای مربوط به نظارت، به روزرسانی و نگهداری سیستمهای هوش مصنوعی

سیستمهای هوش مصنوعی، به ویژه آنهایی که در زمینههای حساس همانند سلامت روان استفاده میشوند، نیاز به نظارت مداوم، به روز رسانی و نگهداری دارند. عملکرد آنها میتواند با گذشت زمان کاهش یابد (drift) یا سوگیریهای جدید ممکن است با تغییر دادههای ورودی ظاهر شوند. اطمینان از اینکه این سیستمها به طور مداوم دقیق، ایمن و اخلاقی عمل میکنند، یک چالش فنی و سازمانی بزرگ است.

چه کسی مسئول نظارت بر عملکرد سیستمهای هوش مصنوعی است؟ چه کسی باید آنها را به روز کند؟ چگونه میتوان اطمینان حاصل کرد که به روز رسانیها سوگیریهای جدیدی را معرفی نمیکنند یا به طور ناخواسته به بیماران آسیب نمیرسانند؟ اینها سؤالات مهمی هستند که نیاز به پاسخهای واضح و چارچوبهای نظارتی قوی دارند. عدم نظارت کافی میتواند منجر به این شود که سیستمهای هوش مصنوعی منسوخ یا معیوب به طور نامناسبی به ارائه مراقبت ادامه دهند.

14. تأثیر بر آموزش روانشناسان آینده

تکیه بیش از حد بر هوش مصنوعی در آموزش روانشناسی میتواند بر نحوه آموزش و توسعه مهارتهای نسل بعدی متخصصان سلامت روان تأثیر بگذارد. اگر دانشجویان بیش از حد به ابزارهای هوش مصنوعی برای تشخیص، برنامه ریزی درمان یا انجام تحقیقات تکیه کنند، ممکن است فرصتهای لازم را برای توسعه مهارتهای اساسی و قضاوت بالینی که در بخشهای قبلی مورد بحث قرار گرفت، از دست بدهند.

برنامههای آموزشی باید به دقت طراحی شوند تا اطمینان حاصل شود که دانشجویان نه تنها نحوه استفاده از هوش مصنوعی را یاد میگیرند، بلکه محدودیتها، خطرات و ملاحظات اخلاقی آن را هم درک می کنند.

آنها باید تشویق شوند که هوش مصنوعی را به عنوان یک ابزار کمکی ببینند، نه یک جایگزین برای تفکر انتقادی، همدلی انسانی و مهارتهای بالینی. آموزش باید بر توسعه تواناییهای انسانی منحصر به فردی تمرکز کند که هوش مصنوعی نمیتواند تکرار کند.

15. از دست دادن شهود و هنر روانشناسی

روانشناسی، فراتر از علم مبتنی بر شواهد، یک هنر هم است. این شامل شهود، خلاقیت، توانایی "خواندن بین خطوط" و درک ظرافت های تجربه انسانی است که اغلب قابل کمی سازی یا الگوریتمی نیستند. تکیه بیش از حد بر هوش مصنوعی که بر دادهها و الگوهای قابل اندازهگیری تمرکز دارد، میتواند منجر به از دست دادن این "هنر" در روانشناسی شود.

شهود بالینی که از سالها تجربه و تعامل با بیماران به دست میآید، به درمانگران اجازه میدهد تا ارتباطات غیر آشکار را برقرار کنند، به نشانههای ظریف توجه کنند و مداخلاتی را انجام دهند که فراتر از پروتکل های استاندارد است. اگر روانشناسان بیش از حد به خروجیهای هوش مصنوعی تکیه کنند، ممکن است این توانایی حیاتی را برای اعتماد به شهود خود و استفاده از خلاقیت خود در درمان از دست بدهند.

پتانسیلهای مثبت هوش مصنوعی در روانشناسی

با وجود خطرات بالقوه، مهم است که اذعان کنیم هوش مصنوعی پتانسیلهای قابل توجهی برای بهبود حوزه روانشناسی هم دارد.

افزایش دسترسی به مراقبتهای بهداشت روان

هوش مصنوعی میتواند به ارائه خدمات بهداشت روان به افرادی که در مناطق دور افتاده زندگی میکنند یا با موانع مالی یا اجتماعی روبرو هستند، کمک کند. چتباتهای هوش مصنوعی و برنامههای کاربردی میتوانند پشتیبانی اولیه و مداخله زودهنگام را ارائه دهند.

بهبود کارایی و کاهش بار کاری

هوش مصنوعی میتواند وظایف اداری وقتگیر همانند برنامهریزی قرار ملاقاتها، یادداشتبرداری و پردازش صورتحساب را خودکار کند و به درمانگران اجازه دهد تا زمان بیشتری را صرف مراقبت از مراجع خود کنند.

ارائه ابزارهای تشخیصی دقیقتر

الگوریتمهای هوش مصنوعی میتوانند حجم وسیعی از دادهها را تجزیه و تحلیل کرده و الگوهایی را شناسایی کنند که ممکن است برای انسان قابل مشاهده نباشند که میتواند منجر به تشخیصهای دقیقتر و زودهنگامتر شود.

شخصیسازی درمان

هوش مصنوعی میتواند به تطبیق برنامههای درمانی با نیازهای فردی مراجع کمک کند و مداخلات هدفمندتر و مؤثرتری را ارائه دهد.

پیشرفت در تحقیقات

هوش مصنوعی میتواند به محققان در تجزیه و تحلیل دادههای پیچیده و کشف بینشهای جدید در مورد سلامت روان و رفتار انسان کمک کند.

کلام پایانی ای سنج درباره خطرات استفاده بیش از حد از هوش مصنوعی در روانشناسی

هوش مصنوعی نویدبخش قابل توجهی برای افزایش کارایی، دسترسی و شخصی سازی در روانشناسی دارد. با این حال، استفاده بیش از حد و نامناسب از آن خطرات قابل توجهی را به همراه دارد که میتواند ماهیت ظریف و پیچیده سلامت روان را تضعیف کند.

از کاهش مهارتهای بالینی و همدلی انسانی گرفته تا نگرانی های مربوط به حریم خصوصی داده ها، تعصب و مسئولیت پذیری، خطرات ناشی از وابستگی بیش از حد به هوش مصنوعی در روانشناسی نباید نادیده گرفته شود.

برای استفاده مسئولانه و اخلاقی از هوش مصنوعی در روانشناسی، رویکردی متعادل و محتاطانه ضروری است. هوش مصنوعی باید به عنوان یک ابزار برای افزایش، نه جایگزینی، تخصص و قضاوت متخصصان انسانی در نظر گرفته شود. حفظ جنبه های انسانی درمان، اطمینان از حریم خصوصی و امنیت دادهها، کاهش تعصب و حفظ مسئولیت پذیری باید در اولویت قرار گیرد.

همانطور که هوش مصنوعی به تکامل خود ادامه میدهد، گفتگوی مداوم بین محققان، متخصصان بالینی، سیاست گذاران و عموم مردم برای درک کامل پیامدهای آن و توسعه دستورالعمل ها و مقرراتی که از استفاده مسئولانه و اخلاقی آن در روانشناسی محافظت میکند، حیاتی است.

تنها از طریق یک رویکرد متفکرانه و آگاهانه میتوانیم از پتانسیل هوش مصنوعی برای بهبود سلامت روان بهره مند شویم و در عین حال از خطرات ناشی از وابستگی بیش از حد به آن جلوگیری کنیم.

اصطلاحات مهم این مقاله

سوالات متداول

-

آیا هوش مصنوعی میتواند جایگزین کامل روانشناس شود؟

- خیر هوش مصنوعی فاقد همدلی، شهود و درک پیچیدگیهای انسانی است که در تعاملات درمانی حیاتی هستند.

-

خطر اصلی تکیه بیش از حد به تشخیصهای هوش مصنوعی چیست؟

- احتمال نادیده گرفتن عوامل انسانی و ظرافتهای تشخیصی و در نتیجه تشخیص نادرست وجود دارد.

-

چگونه استفاده بیش از حد از هوش مصنوعی میتواند رابطه درمانگر و بیمار را تحتتأثیر قرار دهد؟

- میتواند منجر به کاهش تعامل انسانی، اعتماد و در نهایت اثربخشی درمان شود.

-

آیا هوش مصنوعی میتواند در تمام زمینههای روانشناسی به یک اندازه مفید باشد؟

- احتمالاً نه، برخی از حوزهها همانند درمانهای مبتنی بر رابطه انسانی، ممکن است کمتر از حوزههایی همانند تحلیل دادهها از هوش مصنوعی بهرهمند شوند.